+ und einen Verkleinerungsfaktor + und einen Verkleinerungsfaktor  -. Nach

Braun14

haben sich Werte von 1,2 für -. Nach

Braun14

haben sich Werte von 1,2 für  + und 0,5 für + und 0,5 für  - bewährt. - bewährt.

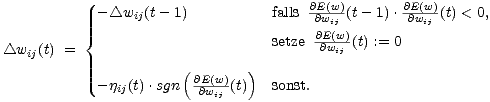

Die Gewichtsänderung

Im ersten Fall der Gleichung (5.12) wird die vorangegangene Gewichtsänderung rückgängig gemacht und die Schrittweite verringert. Dies bedeutet anschaulich, daß man den letzten Schritt zurücknimmt und es mit kleinerer Schrittweite noch einmal versucht. Zusätzlich wird der Gradient zum Zeitpunkt t auf 0 gesetzt, damit sich im nächsten Schritt das Vorzeichen nicht ändert, wodurch der Betrag der Gewichtsänderung auch bei Erfolg erneut verringert würde. Der RPROP Algorithmus hat sich in vielen Untersuchungen als sehr schnell und robust erwiesen.15

5.1.3. Relative BewertungenTrainingsbeispiele für ein neuronales Netz können aus Bewertungen eines menschlichen Experten stammen, z.B. die Bewertung eines Spielstandes beim Mühlespiel oder die Bewertung einer Interpretation von Sequenzen, wie im zweiten Teil dieser Arbeit. Bei der Bewertung durch menschliche Experten ist es häufig ein Problem, die Konsistenz der Bewertungen sicherzustellen. Diese stellen sich im nachhinein oft als widersprüchlich heraus und müssen nach der Präsentation neuer Beispiele revidiert werden. Menschen fällt es im allgemeinen leichter, von zwei Alternativen die bessere zu bestimmen als absolute Bewertungen abzugeben. Für ein neuronales Netz mit Gradientenabstieg als Lernverfahren haben Braun, Feulner und Ulrich eine Methode vorgestellt, die es ermöglicht, das Netz anhand relativer Bewertungen zu trainieren.16 Dazu wird das Netz N für die beiden zu vergleichenden Beispiele dupliziert. Man erhält zwei identische Netze, ein linkes und ein rechtes, und verbindet deren Ausgabeneuronen mit einem Komparatorneuron K, wie in Abbildung 5.4 dargestellt. Die einander entsprechenden Gewichte in beiden Netzen werden mit Weight-Sharing verbunden, d.h. die Gewichte werden immer auf dem gleichen Wert gehalten, und beim Training werden die Fehlerterme aus beiden Netzen addiert. An die beiden Netze werden als Eingabedaten die jeweils vom Experten besser bewertete Variante (links) und die schlechter bewertete Variante (rechts) angelegt.Die Verbindungen zum Komparatorneuron haben die Gewichte -1 bzw. 1 für das linke bzw. rechte Netz. Diese Werte werden auch während des Trainings nicht verändert. Seien xl das vom Experten besser bewertete Beispiel und xr das schlechter |