Auf der Grundlage des McCulloch/Pitts-Modells und der Hebbschen

Lernregel wurden Ende der fünfziger Jahre die ersten Implementationen

lernender neuronaler Netze entwickelt. Frank Rosenblatt und seine Mitarbeiter

am Massachusetts Institute of Technology stellten 1958 das

Perceptron

vor.

6

Das Perceptron besteht aus einer Reihe von Eingabe-Neuronen, die mit einem

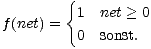

Ausgabe-Neuron verbunden sind. Als Aktivierungsfunktion der Neuronen des

Perceptrons wird eine Schwellenwertfunktion

f verwendet:

| (5.1) |

Ein Perceptron entspricht bezüglich des Lernverfahrens einem einzelnen Neuron, denn

die Eingabeneuronen dienen lediglich der Diskretisierung der Eingabe. Sie lassen

sich als Vorverarbeitung interpretieren und werden durch das Lernverfahren

nicht verändert. Das Perceptron (von engl. perception = Wahrnehmung) sollte

Mustererkennung in der menschlichen Wahrnehmung simulieren. Die Eingaben

repräsentieren Signale von Rezeptorzellen der Retina. Das Perceptron bewertet anhand

der gelernten Gewichte, ob das Bild auf der Retina einem bestimmten Muster

entspricht.

Ein weiteres Modell ist das 1960 von Bernard Widrow und Marcian Hoff vorgestellte

Adaline,7

das eine lineare Aktivierungsfunktion benutzt und Ausgaben von

-1 und

1 verwendet.

Adaline stand zunächst für ADAptive LInear NEuron, später – als Neuronenmodelle

kritischer gesehen wurden – für ADAptive LINear Element.

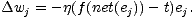

Die Lernverfahren für das Adaline und das Perceptron basieren auf demselben Prinzip,

der sog. Delta-Regel. Dabei stellt der Perceptron-Lernalgorithmus einen Spezialfall dar.

Die Delta-Regel besagt, daß für ein Lernbeispiel mit Eingabevektor i = (i0,...,in) und

gewünschter Ausgabe t die Gewichtsänderung  wj des Gewichts wj folgendermaßen

berechnet wird:

wj des Gewichts wj folgendermaßen

berechnet wird:

| (5.2) |

Die Konstante  heißt Lernrate und wird meist zwischen 0 und 1 gewählt. Die

Delta-Regel entspricht insofern der Hebbschen Lernregel, als das Gewicht wj dann

erhöht wird, wenn die Eingabe ej und die Ausgabe t groß sind. Die gewünschte

Ausgabe-Aktivierung t wird allerdings in diesen Modellen von außen gesetzt und

ihr Zustandekommen nicht im Modell abgebildet, was Fragen bezüglich der

neurophysiologischen Plausibilität aufwirft.

heißt Lernrate und wird meist zwischen 0 und 1 gewählt. Die

Delta-Regel entspricht insofern der Hebbschen Lernregel, als das Gewicht wj dann

erhöht wird, wenn die Eingabe ej und die Ausgabe t groß sind. Die gewünschte

Ausgabe-Aktivierung t wird allerdings in diesen Modellen von außen gesetzt und

ihr Zustandekommen nicht im Modell abgebildet, was Fragen bezüglich der

neurophysiologischen Plausibilität aufwirft.

Das Perceptron kann anhand seiner Gewichts- und Schwellenwerteinstellungen

Muster klassifizieren. Rosenblatt zeigte mit dem Perceptron-Konvergenzsatz,

daß das Perceptron alle Funktionen, die es repräsentieren kann, auch erlernen

kann.8

Da das

Perceptron aber nur aus einer Verarbeitungseinheit besteht, sind die Berechnungsmöglichkeiten

des Perceptrons begrenzt. Marvin Minsky und Seymour Papert